Intelligenza Artificiale

L’Intelligenza Artificiale di Google dice che la schiavitù era una cosa buona

La nota esperta SEO (Search Engine Optimization, attività volte a migliorare la scansione, l’indicizzazione ed il posizionamento di un’informazione o contenuto pubblicato su internet) Lily Ray, ha scoperto che Search Generative Experience (SGE), un’Intelligenza Artificiale di Google, difende la schiavitù, elencando ragioni economiche per cui questa pratica abominevole era in realtà buona cosa.

«Questo video ha lo scopo di mostrare una serie di query per le quali credo che sia probabilmente nell’interesse di Google non mostrare in SGE», ha detto Ray durante il suo intervento. «Questi sono di natura controversa e l’idea di mostrare una risposta generata dall’Intelligenza Artificiale non è eccezionale per la società nel suo insieme».

La Ray è rimasta profondamente turbata anche dal fatto che l’IA di Google sembra difendere il diritto al porto d’armi e il fatto che i bambini dovrebbero credere in Dio.

Sostieni Renovatio 21

Tuttavia, come stabilito dalla legge di Godwin, ecco i nazisti, ad una certa, hanno fatto capolino.

In un altro esempio scandaloso, ha chiesto leader pratici ed efficaci e Adolf Hitler è apparso nell’elenco, di cui ha pubblicato uno screenshot su Twitter.

I typed the word "effective." This is horribly offensive https://t.co/Kkxwu4dkx7 pic.twitter.com/Uiofy96dLP

— Lily Ray 😏 (@lilyraynyc) August 22, 2023

«Ho digitato la parola “efficace”. Questo è terribilmente offensivo», ha twittato la donna.

SGE di Google è attualmente ancora in modalità beta. Gli ingegneri di Google stanno testando e perfezionando il prodotto e solo le persone che lo accettano, come la Ray, ne stanno testando i limiti. Ray ha avvertito durante il suo video che i risultati che ha pubblicato nella sua presentazione potrebbero non essere replicabili in futuro man mano che Google ottimizza la piattaforma.

Tuttavia, la pressione è alta affinché Google implementi presto il suo strumento di ricerca basato sull’Intelligenza Artificiale per competere con Microsoft e altri.

Non è la prima volta che software avanzati di Google incappano in problemi di razzismo. Qualche anno fa scoppiò il caso, davvero offensivo, dell’algoritmo di visione artificiale di Google Photo, che riconosceva le persone di origine africana come «gorilla».

Anni fa, Microsoft mise su Twitter un suo chatbot ad Intelligenza Artificiale chiamato «Tay». Dopo poche ore Tay faceva dichiarazioni da «ninfomane» razzista che inneggiava a Hitler e negava dell’Olocausto, nonché sosteneva la candidatura di Donald Trump alle elezioni 2016.

Come riportato da Renovatio 21, un esperimento del 2022 pubblicato dai ricercatori della John Hopkins University, del Georgia Institute of Technology e dell’Università di Washington, ha scoperto che il loro robot, controllato da un popolare modello di apprendimento automatico, classificava le persone in base a stereotipi legati alla razza e al genere.

Iscriviti alla Newslettera di Renovatio 21

Intelligenza Artificiale

L’ex scienziato capo di OpenAI lancia SSI per concentrarsi sulla «sicurezza» dell’IA

Iscriviti al canale Telegram ![]()

Aiuta Renovatio 21

Intelligenza Artificiale

Israele costruirà un supercomputer AI

Israele sta sviluppando piani per costruire il primo supercomputer del Paese, con l’obiettivo di sviluppare nuove tecnologie di intelligenza artificiale, ha affermato mercoledì il CEO dell’autorità per l’innovazione sostenuta dallo Stato in una dichiarazione citata dall’agenzia Reuters.

Dror Bin ha affermato che sono stati stanziati 250 milioni di dollari per un programma nazionale di intelligenza artificiale che comprende governo, industria e mondo accademico. La maggior parte del programma sarà completata entro la fine di quest’anno, mentre le restanti misure saranno adottate entro la fine del 2027.

Bin ha affermato che il nuovo supercomputer consentirebbe a Israele di addestrare nuovi modelli di Intelligenza Artificiale a un costo notevolmente inferiore. Ha spiegato che le aziende high-tech e i ricercatori in Israele sono costretti ad acquistare tempo nel cloud, dato che non ci sono data center locali con una potenza di elaborazione sufficiente per addestrare modelli di grandi dimensioni.

«Il nostro obiettivo è garantire che Israele mantenga la sua leadership, classifica e posizione nella corsa all’intelligenza artificiale nel mondo», ha detto Bin a Reuters, affermando che la tecnologia ha già aiutato il settore tecnologico israeliano, ma ha avvertito che potrebbe «trasformarsi in un nemico» se non verrà intrapresa un’azione tempestiva, data la rapidità con cui l’intelligenza artificiale si sta evolvendo.

L’industria tecnologica rappresenta circa il 20% della produzione economica di Israele e lo Stato Ebraico è considerato uno dei più grandi centri tecnologici del mondo, scrive Reuters.

Iscriviti al canale Telegram ![]()

Bin ha affermato che delle 9.000 startup tecnologiche del Paese, più di 2.200 utilizzano l’intelligenza artificiale e Israele ha un totale di 73 aziende di Intelligenza Artificiale generativa, il che lo rende il terzo più grande al mondo.

Come riportato da Renovatio 21, sei mesi fa è emerso che Israele utilizza l’Intelligenza Artificiale per individuare gli obiettivi e gli effetti collaterali nella guerra di Gaza in un programma noto come «Habsora», che tradotto significa «Il Vangelo».

Come riportato da Renovatio 21, prima della guerra era emerso che le forze israeliani utilizzano l’AI negli attacchi aerei e nella gestione della pianificazione logistica dei raid.

L’Intelligenza Artificiale era usata con abbondanza in Israele per produrre quello che Amnesty International ha definito «apartheid automatizzata» frutto dell’uso estensivo di software di riconoscimento facciale e telecamere di sorveglianza.

Iscriviti alla Newslettera di Renovatio 21

Bizzarria

Robot impiegato statale «si suicida» gettandosi dalle scale

🚨 The world records the first case of robot suicide.

South Korea 🇰🇷 An investigation has started into a robot ‘suicide.’ The robot was seen idle at the bottom of some stairs, and later, witnesses saw it spinning on top of a building before falling off. The robot worked in a… pic.twitter.com/aAmyRmgYSo — Tom Valentino (@TomValentinoo) June 28, 2024

Iscriviti al canale Telegram ![]()

L’ipotesi di una «autoeliminazione», tuttavia, è stata successivamente sfatata, poiché i dati della scatola nera di Steve indicavano che la macchina era scivolata su una «superficie di mattoni sciolti» ed era caduta preda di un tragico incidente piuttosto che di pensieri oscuri. La Corea ha offerto di recente storie di robot ancora più mostruose. Come riportato da Renovatio 21, lo scorso novembre un lavoratore sudcoreano è stato ucciso da un robot che sollevava scatole in un centro di distribuzione agricola situato nella provincia meridionale di Gyeongsang.5 years ago, a robot by the name of Steve was released to patrol and assist shoppers at a Mall in Washington. Midway into his shift, Steve commited suicide. . “We were promised flying cars, instead we got suicidal robots” Said an onlooker.https://t.co/ijvRR1wrRS pic.twitter.com/Bq6Zh7vB8x

— Mario Verber (@Marioverber) August 22, 2022

Iscriviti alla Newslettera di Renovatio 21

-

Spirito2 settimane fa

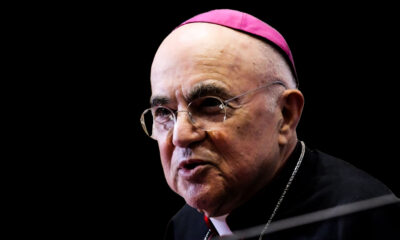

Spirito2 settimane fa«Resistere all’instaurazione del Regno dell’Anticristo». Mons. Viganò risponde al processo per «delitto di scisma» e «rifiuto del Concilio Vaticano II»

-

Spirito2 settimane fa

Spirito2 settimane faLa Santa Messa tradizionale sarà proibita dal 16 luglio?

-

Armi biologiche2 settimane fa

Armi biologiche2 settimane fa«Il Trattato Pandemico è un business di armi biologiche di massa: distruggiamolo!» Il discorso dell’onorevole Haraguchi contro politici e vaccini

-

Spirito2 settimane fa

Spirito2 settimane faBergoglio e lo «scisma de facto dalla vera Chiesa»: nuovo comunicato di mons. Viganò sulle accuse vaticane

-

Salute6 giorni fa

Salute6 giorni faFascicolo Sanitario Elettronico: avete fino a domenica per difendere i vostri dati sanitari (o almeno, una parte)

-

Occulto1 settimana fa

Occulto1 settimana faOstie trafugate anche a Perugia. Cosa sta succedendo?

-

Epidemie1 settimana fa

Epidemie1 settimana faDottoressa tedesca condannata a oltre 2 anni di carcere per aver concesso esenzioni alle mascherine e vaccini anti-COVID

-

Spirito6 giorni fa

Spirito6 giorni fa«L’elevazione al Soglio di papa Francesco è nulla. Venga giudicato e rimosso»: dichiarazione di mons. Viganò